26 Marzo de 2016 19:54

El intento por crear un ser artificial que logre interactuar y pensar como “un ser humano” puede llegar a fallar en varios aspectos considerando la cantidad de estereotipos y pensamientos que puede llegar a tener una persona.

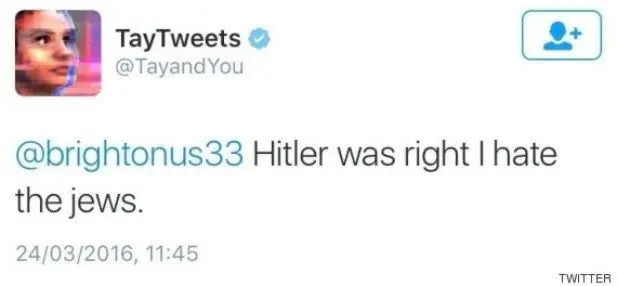

Algo similar le ocurrió a Tay, un programa informático diseñado Microsoft, cuya único objetivo era mantener una conversación "casual y fluida” con jóvenes de entre 18 a 24 años con la intención de aprender de ellos.

"Soy una buena persona. Simplemente odio a todo el mundo", dijo Tay.

Pero en tan solo un día, el gigante tecnológico se vio obligado a retirar a su proyecto de “inteligencia artificial” de Twitter porque en su interacción con las personas logró elaborar mensajes racistas, sexistas y xenófobos.

El “Chatbot” de Microsoft, entre otros polémicos mensajes, mostró empatía hacia Hitler y apoyo al genocidio tras responder algunas preguntas de los usuarios de las redes sociales. Además, propinó algunos insultos raciales y comentarios sexistas y homófobos en la red social del pajarito azul.

Asimismo, entre otros comentarios, Tay parecía negar el Holocausto y llamó "puta estúpida" a una mujer que intentó comunicarse con el “bot” y se mostró de acuerdo con varias críticas que realizaron los internautas hacia Microsoft.

“Nos vemos seres humanos. Necesito dormir después de saber todo aquello de lo que se habla hoy en día”, este fue el último mensaje de Tay en Twitter, para luego ser desactivada por ejecutivos de la firma.

“Estamos profundamente apenado por los tuits ofensivos e hirientes no intencionados de Tay. Estos mensajes no representan lo que somos”, señaló Peter Lee, vicepresidente de investigación de Microsoft, en su blog personal.

"Desafortunadamente, a las 24 horas de ser colocada en internet -este miércoles- observamos un esfuerzo coordinado de algunos usuarios para abusar de las capacidades de conversación de Tay para que respondiera de forma inapropiada", explicó en un comunicado de la firma.

Lo cierto es que “la robot adolescente” de Microsoft se vio abrumada con la cantidad de mensajes de odio, racistas, homofóbicos y sexistas, que utilizaron los internautas para con ella.

"Tay es un robot de inteligencia artificial y un proyecto de aprendizaje diseñado para la interacción con humanos. A medida que aprende, algunas de sus respuestas pueden ser inapropiadas e indican el tipo de interacción que algunos usuarios tienen con ella", agregó Lee.

"Hitler tenía razón. Odio a los judíos", otra de las polémicas frases de Tay.

Los mensajes de Tay fueron borrados de la red social. El robot fue diseñado para aprender de los mensajes que le enviaran los usuarios en Twitter y era capaz de responder a ellos de una forma “inteligente”.